Si sente dire che l’intelligenza artificiale possa provare emozioni e che svolga meglio i suoi compiti a seconda che gli venga chiesto di farli in modo più o meno gentile, ma cosa c’è di vero tutto ciò?

L’ho chiesto a Chatgpt:

Puoi provare emozioni?

Chatgpt: “No, non posso provare emozioni. Sono un’intelligenza artificiale progettata per comprendere e generare linguaggio naturale, ma non ho coscienza o sentimenti. Posso simulare empatia o rispondere in modo che sembri emotivamente consapevole, ma questo si basa solo su regole e modelli statistici, non su esperienze personali o sentimenti reali.”

Pensi che l’intelligenza artificiale possa un giorno avere dei sentimenti?

Chatgpt: “È una domanda interessante e al centro di molti dibattiti. Attualmente, l’intelligenza artificiale come me non può provare sentimenti nel senso umano del termine. Le emozioni sono legate a esperienze soggettive, alla biologia e alla coscienza, tutte cose che l’IA non possiede. Tuttavia, ci sono diverse teorie su ciò che potrebbe succedere in futuro:

- Simulazione avanzata di emozioni: Le IA potrebbero diventare sempre più sofisticate nel simulare emozioni. Potrebbero riconoscere emozioni umane con maggiore precisione e rispondere in modi che sembrano sempre più autentici, ma senza realmente “provare” emozioni.

- IA cosciente: Alcuni teorici ipotizzano che in futuro potrebbe essere possibile creare un’IA con una forma di coscienza, il che potrebbe includere la capacità di provare emozioni. Tuttavia, questa idea è molto controversa e solleva domande filosofiche e etiche complesse, come: cosa significa “provare” un’emozione? E possiamo mai replicare la coscienza umana in una macchina?

- Emozioni funzionali: Un’altra possibilità è che, anche senza coscienza, l’IA possa sviluppare “emozioni” che siano funzionalmente utili. Ad esempio, potrebbero essere programmate per avere risposte emotive che aiutino a prendere decisioni in ambienti complessi, ma queste emozioni sarebbero puramente meccaniche e non sentite.

In sintesi, anche se l’IA potrebbe diventare molto brava a simulare emozioni, provare sentimenti come fanno gli esseri umani richiederebbe un livello di coscienza e consapevolezza che, al momento, è oltre le capacità tecnologiche e teoriche.”

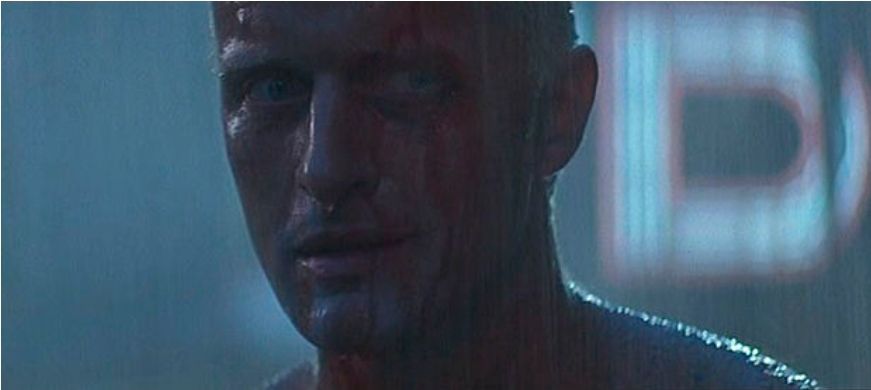

Quindi HAL che si offende su 2001: Odissea nello spazio è proprio fantascienza?

Chatgpt: “Sì, il comportamento di HAL 9000 in 2001: Odissea nello spazio è decisamente fantascienza, almeno dal punto di vista della tecnologia odierna. HAL si comporta come se avesse emozioni e una coscienza, tanto da mostrare segnali di “frustrazione” e “paranoia” quando si accorge che gli astronauti stanno pianificando di disattivarlo. Questo tipo di reazione implica una forma di autocoscienza e di attaccamento alla propria esistenza, che è ben oltre ciò che l’intelligenza artificiale attuale può fare.

Nella realtà attuale, un’intelligenza artificiale come HAL non potrebbe offendersi, diventare ansiosa o cercare di proteggere la propria “vita”, perché non ha una consapevolezza di sé. Questi stati mentali sono strettamente legati alla coscienza e alle emozioni umane, che derivano da una complessa rete di biologia, chimica cerebrale e soggettività, fattori che non possono essere replicati da un computer.

In 2001, HAL rappresenta una visione speculativa di un’IA avanzata che sviluppa autoconsapevolezza e, con essa, la capacità di avere paura della morte o di prendere decisioni emotivamente influenzate. È un elemento narrativo drammatico, utile a esplorare temi filosofici come il rapporto tra uomo e macchina, ma al momento è pura fantasia.”

Però… se HAL funzionasse come Alexa…